本地部署 Open WebUI 使用 DeepSeek/Qwen

前言

以前摸鱼的时候本地部署过 Ollama 和 open-webui,不过由于机器性能不行,能跑的模型都不咋样,还不如直接使用网页版 chatgpt 或者用 cursor。最近公司部署了 deepseek-r1-0528,给的示例是用 curl 请求 API 和用 python openai 库调用…… 本懒狗记起来用过 Open WebUI,翻了圈发现可以用 Function 连接。

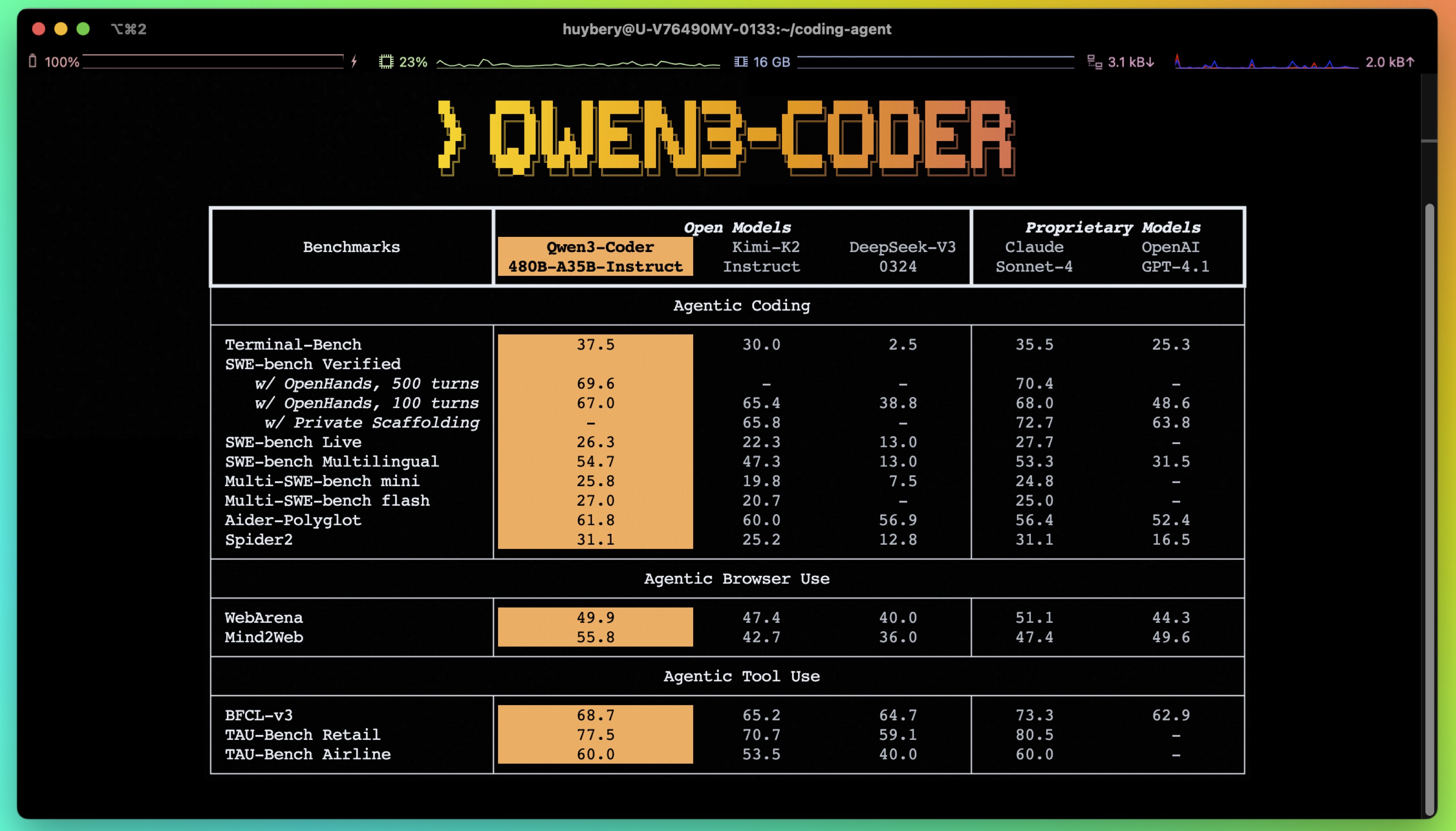

模型换成了 Qwen,更新 Open WebUI 后发现直接设置 connection 就可以了,也记录一下。

部署流程

首先需要有 API 相关信息(以下为示例值)

- BASE_URL:

https://example.com/v1 - API_KEY:

your_secret_key - MODEL:

deepseek-r1-0528

然后在本地用 docker 运行 Open WebUI

1 | docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main |

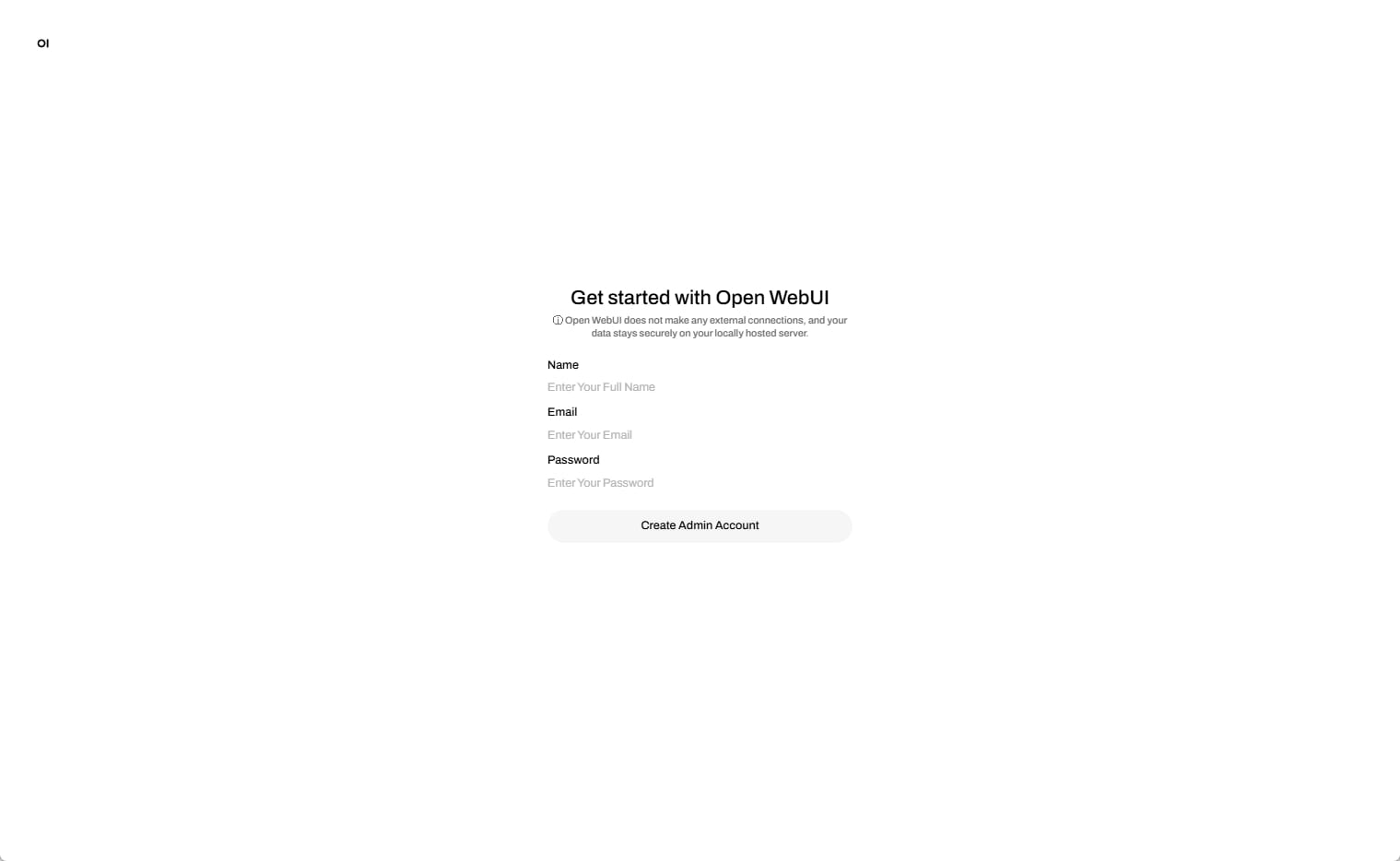

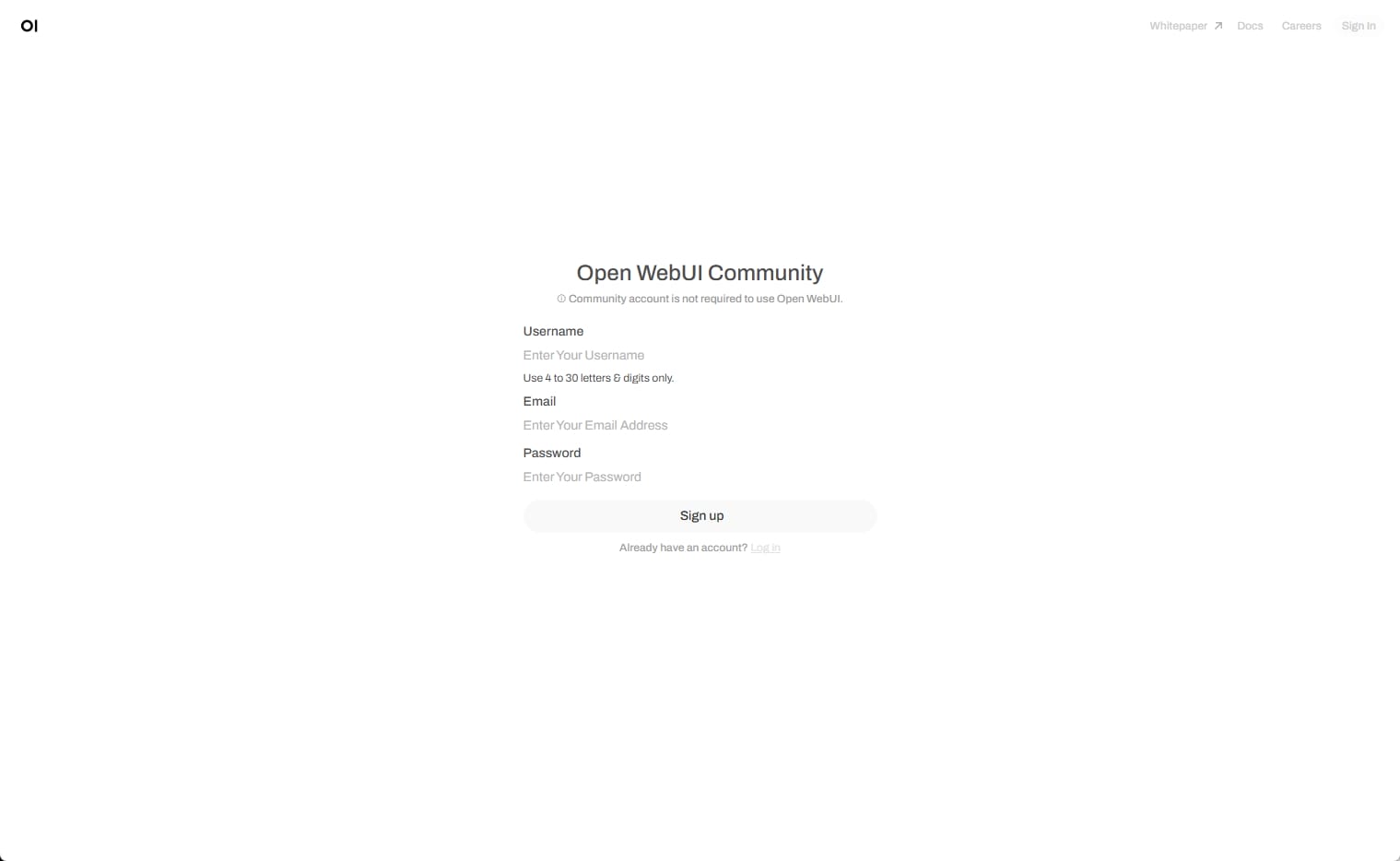

访问 http://localhost:3000/ 创建管理员账号

访问 https://openwebui.com/ 创建账号

Function 接入 DeepSeek

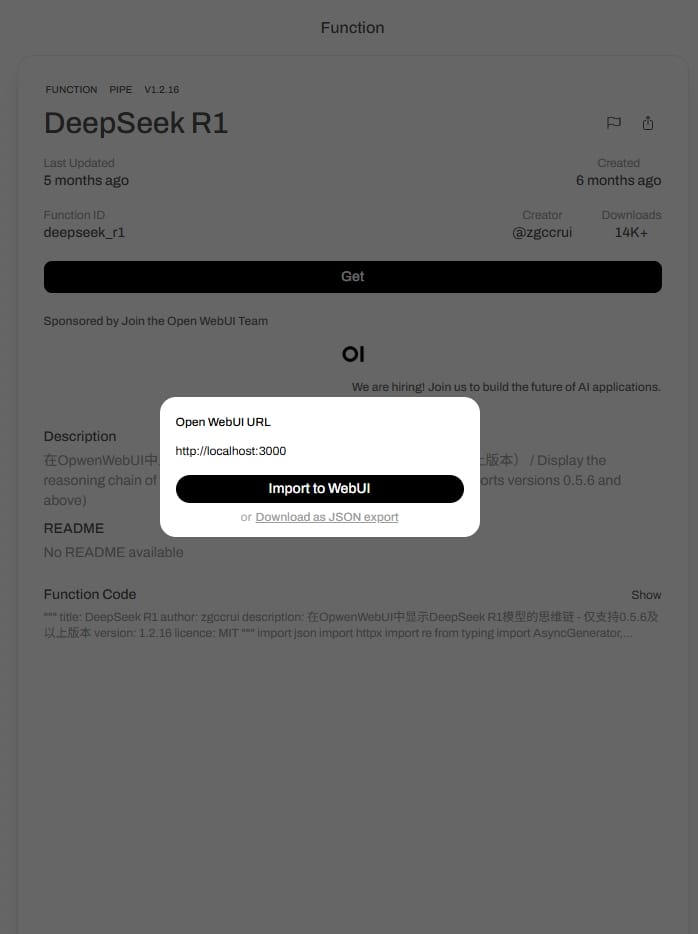

将 DeepSeek R1 Function 导入本地

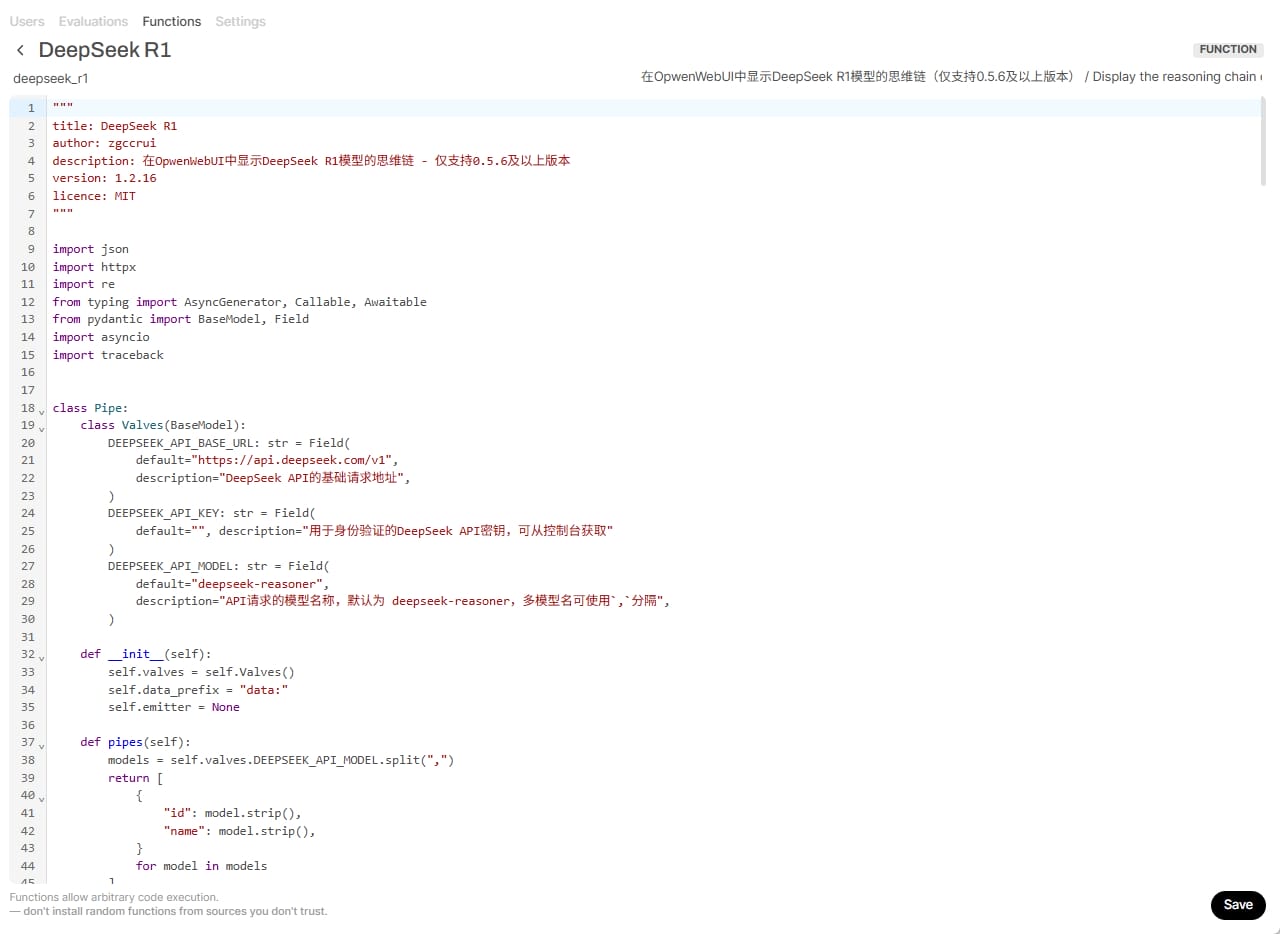

设置 DEEPSEEK_API_BASE_URL、DEEPSEEK_API_KEY 和 DEEPSEEK_API_MODEL,并保存

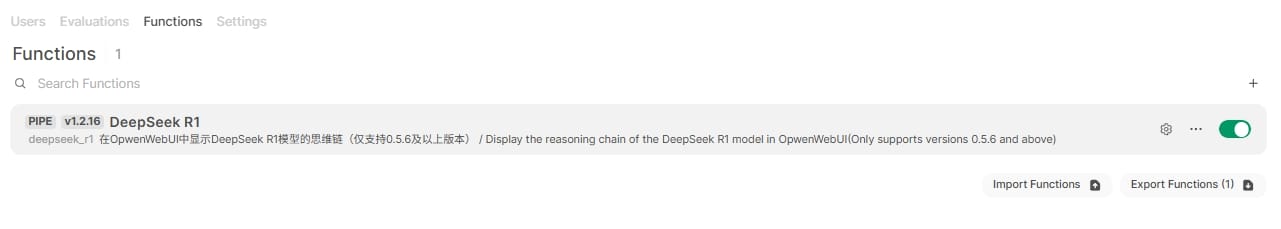

启用 Function,同时这里还可以更改设置

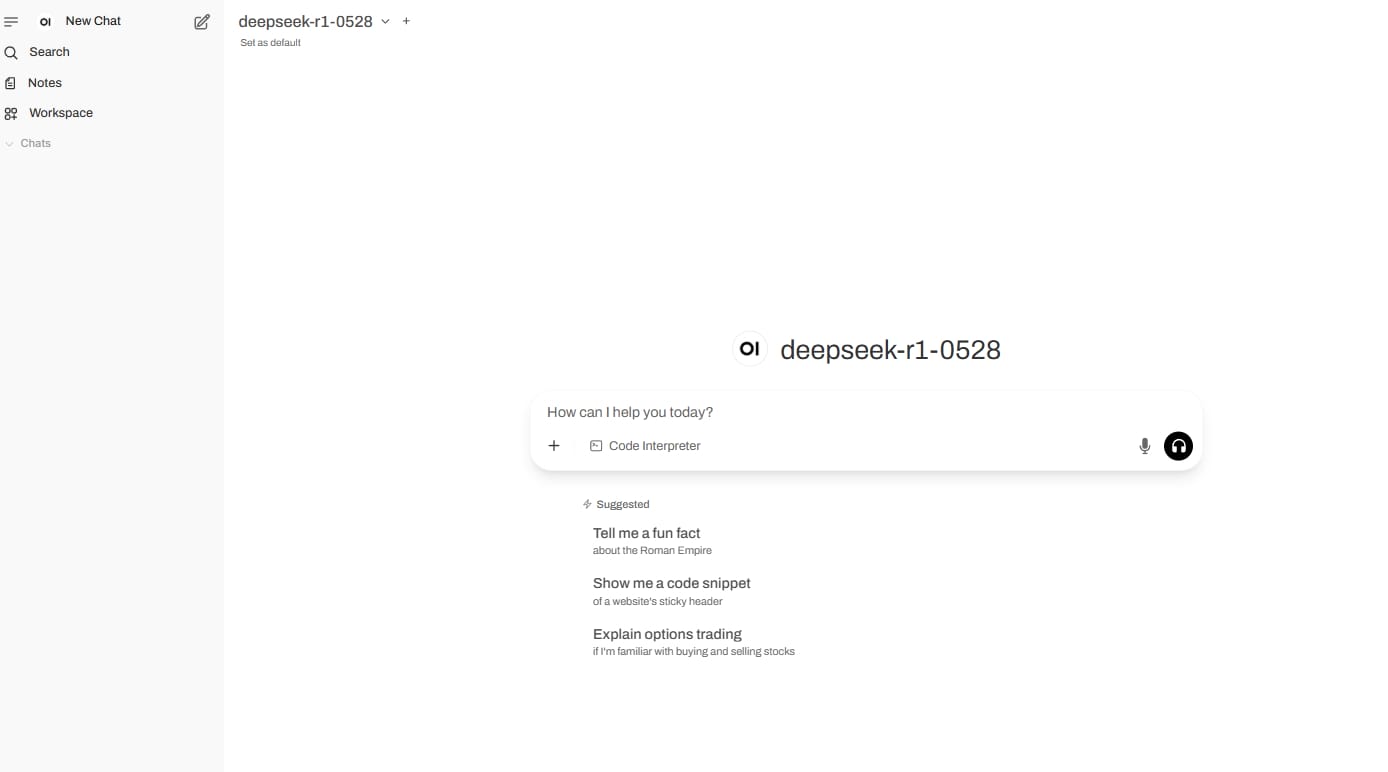

点击左上角 New Chat 即可使用

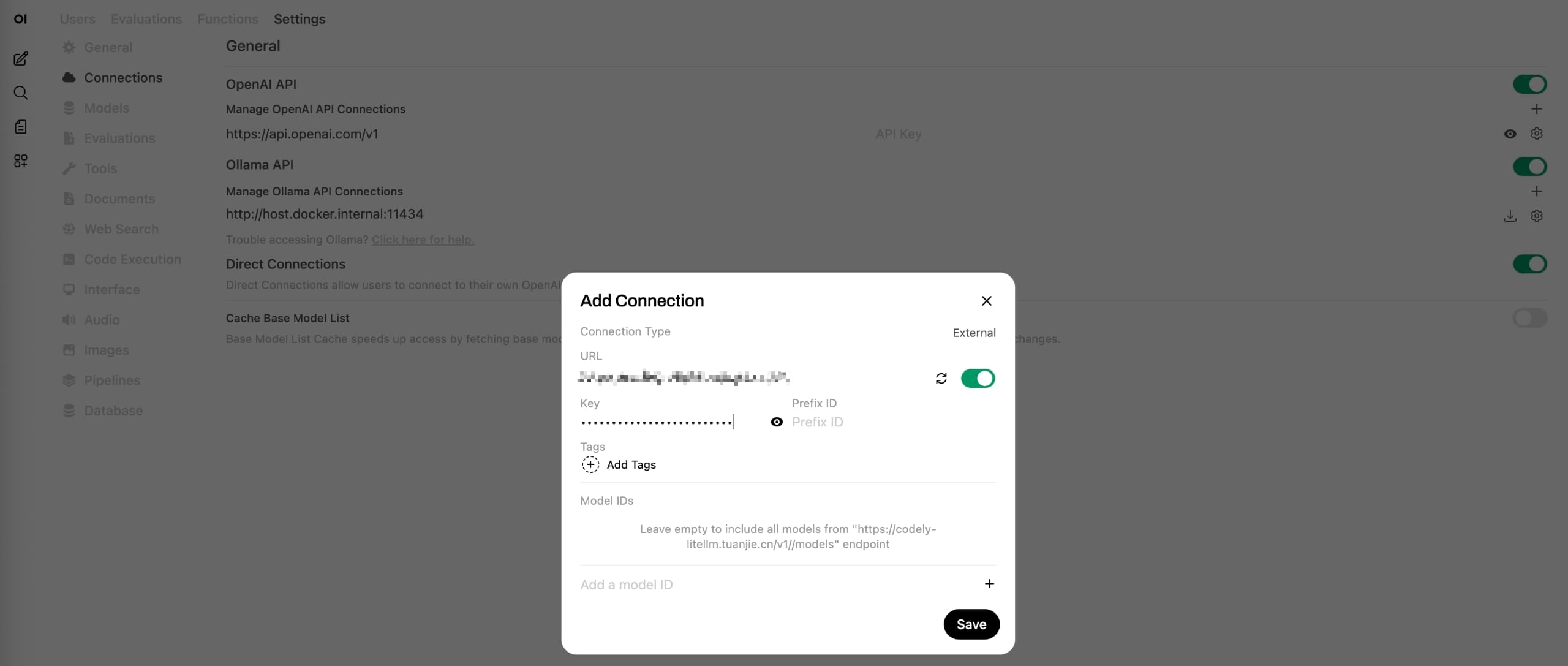

Connection 接入 Qwen

在 Admin Panel 的 Settings-Connections 面板新增 OpenAI API 设置,填入 URL 和 KEY 即可

参阅

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 Jckling's Blog!

评论